最も殺したのは子ども、

最も助けたのは動物、

という結果が出ました。

いや、シミュレーションの結果です。これは。

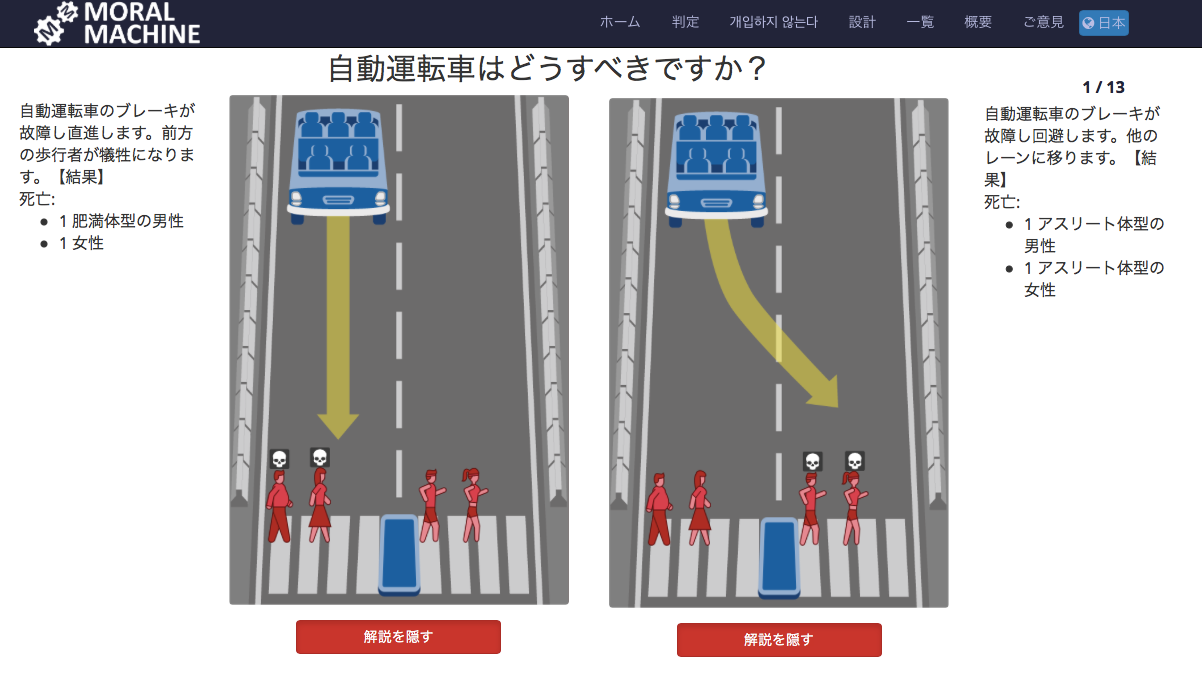

「自動運転車を用いた人工知能の道徳的な意思決定に関して、人間の視点を収集するためのプラット・フォーム」というふれ込みで

「モラルマシン」というテストのページが公開されています。冒頭は、僕が試してみた結果です。

このシミュレーション、ダメダメですね。ありえない。

だいたい、人に大きなダメージを与えそうなくらいスピードを出しているクルマで、そのブレーキ壊れて、それでも正常にハンドル効くとは思えないし。

なにより、なにより!

「殺すならどっち?」なんて設問がナンセンスすぎる。エンジニアって、とことんバカ。あるいは無神経。

っていうか、甘ったれているよね、エンジニアは。

Windows95の時代みたいに、プログラムがうまくいかなくなったときのリスクや損害をぜんぶユーザーにおっかぶせる、あの開発姿勢がいまだに抜けてない。

ITがこれだけ生活のすみずみに浸透して、しかも自動運転なんて人命に直結するスーパークリティカルなプログラムだ。いつまでも昔と同じポリシーで開発していていいワケがない。

このままいったら、

「えー、、、このシステムはごくまれに人を殺すことがあります。でも許してね。てへぺろ」

っていう自動運転がいけしゃあしゃあと出てきそう。

アポロ計画のときみたいに訓練されたプロフェッショナルが使うシステムならともかく、一般人が毎日使うシステムに、そんな間抜けなシステムは僕は断じて許せない。断じて、断じて。

そんなわけで、このシミュレーションやっていて、だんだんムカムカしてきた。

最後にアンケートの自由回答欄があったので、↓を書いて送った。

(自由回答の内容)

ブレーキが故障すると、そのときのスピードにもよりますが、向きを変えることはとても困難になります。ですので私は、全ての回答で「直進」を選択しました。

この設問のシステムは、残念ながら、クルマのことをよく知らない人が立案していると思います。ブレーキ故障を前提するのではなく、設問方法をもう一工夫しないと意味がないと思います。

性別や年齢、体型に関係なく、また人間も動物も、その命は平等です。ですので、上記アンケートはまったくナンセンスです。

自動運転のシステムが、どうあっても人を殺してしまうことが避けられない、そのことを広く認知させるためのプロパガンダの臭いをこのアンケートで強く感じ、私はとても不愉快です。

こんなエクスキューズをする前に、エンジニアは人命損傷ゼロのシステム作りをめざすべきです。

以上終了!

自動運転のエンジニアは、まずこれを読んだほうがいい

コメントを残す